LLM(Large Language Model)은 방대한 양의 텍스트 데이터를 학습하여 만들어진 인공지능 언어 모델입니다. 이 모델은 GPT-3, BERT, T5 등 다양한 종류가 있으며, 사용자의 입력에 따라 인간과 유사한 텍스트를 생성할 수 있습니다. LLM은 기계 번역, 문서 요약, 질의응답, 대화 시스템 등 다양한 자연어 처리 분야에서 활용되고 있습니다.

LLM 모델을 로컬에서 가동한다는 것은 클라우드 서비스를 통해 모델을 사용하는 것이 아니라, 사용자의 개인 컴퓨터에 모델을 설치하여 직접 실행하는 것을 의미합니다. 이를 통해 인터넷 연결 없이도 모델을 사용할 수 있으며, 개인 정보 보호 측면에서도 장점이 있습니다. 하지만 로컬 가동을 위해서는 충분한 하드웨어 성능과 저장 공간이 필요합니다.

WebUI는 Web-based User Interface의 약자로, 웹 브라우저를 통해 접근할 수 있는 사용자 인터페이스를 말합니다. LLM 모델을 로컬에서 가동할 때, WebUI를 사용하면 웹 브라우저를 통해 모델과 상호작용할 수 있습니다. 이를 통해 사용자는 편리하게 모델을 테스트하고 활용할 수 있습니다.

해당 블로그 글에서는 LLM 모델을 Windows 환경에서 로컬로 가동하는 방법과 WebUI를 통해 모델을 사용하는 과정을 단계별로 설명할 예정입니다. 이를 통해 여러분도 직접 LLM 모델을 체험하고, 다양한 자연어 처리 태스크에 활용해 볼 수 있을 것입니다.

Webui 목록

머니두잇은 여러가지 webui를 사용했습니다. 여러 webui 중에서 어느 것이 편할지는 여러분들이 선택해서 활용하시면 됩니다. 개인적으로 사용하기 간편한 것은 lmstudio가 최고였으며, 그 다음으로 간편했던 것은 Ai 채팅 로컬에서 자주 활용되는 우바부가였습니다. ollama-webui 또한 편하지만 설치하기가 귀찮은 측면이 있습니다. (docker를 설치해야 하는데, 오류가 많았음)

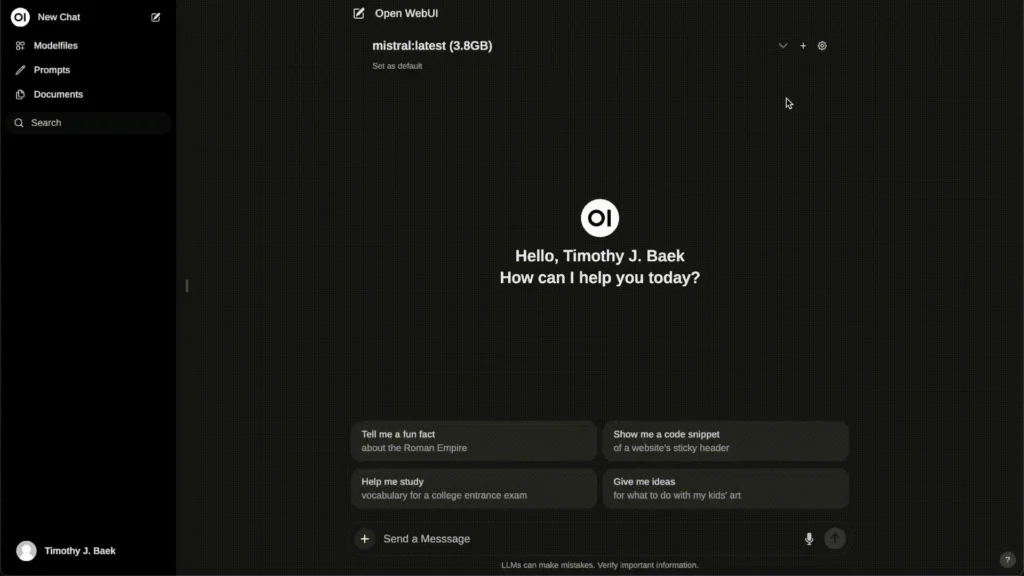

ollama-webui

https://github.com/open-webui/open-webui

Ollama는 Llama2, Mistral, Gemma 등 대규모 언어 모델(LLM)을 개인용 컴퓨터에서 쉽게 실행할 수 있게 해주는 오픈소스 프로젝트입니다. 이를 통해 사용자는 명령창에서 직접 언어 모델과 대화할 수 있습니다. 하지만 많은 사용자들에게는 ChatGPT처럼 웹 브라우저에서 주고받는 대화 형식이 더욱 익숙할 것입니다.

이런 사용자들을 위해 Ollama-WebUI라는 프로젝트가 개발되었습니다. Ollama-WebUI는 Ollama와 결합하여 ChatGPT와 유사한 형태로 LLM 모델을 사용할 수 있게 해줍니다. 웹 브라우저를 통해 모델과 상호작용할 수 있어 사용자 친화적인 인터페이스를 제공합니다.

다만 Ollama는 OpenAI 형식의 API 엔드포인트를 지원하지 않는다는 점이 아쉽습니다. 이는 Ollama를 다른 서비스나 애플리케이션과 연동할 때 제한 사항이 될 수 있습니다. 대안으로는 Oobabooga라는 프로젝트가 있지만, 이를 사용하기 위해서는 추가적인 학습이 필요해 보입니다.

전반적으로 Ollama-WebUI는 LLM 모델을 로컬에서 쉽게 사용할 수 있게 해주는 유용한 프로젝트입니다. ChatGPT와 유사한 사용자 경험을 제공하면서도 개인 정보 보호와 보안 측면에서 장점을 가지고 있습니다. 앞으로도 Ollama-WebUI의 발전과 개선을 기대해 봅니다.

설치방법

Docker를 이용한 설치

Ollama가 로컬 컴퓨터에 있는 경우 다음 명령어를 사용하여 Docker 컨테이너를 실행합니다.

run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainOllama가 다른 서버에 있는 경우 OLLAMA_BASE_URL 환경 변수를 설정하여 Ollama 서버의 URL을 지정합니다.

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main설치가 완료되면 http://localhost:3000에서 Oobabooga의 WebUI에 접속할 수 있습니다.

트러블슈팅

만약 서버 연결 오류가 발생한다면, Docker 컨테이너 내부에서 Ollama 서버에 접근할 수 없기 때문일 가능성이 높습니다. 이 경우 --network=host 옵션을 추가하여 문제를 해결할 수 있습니다.

Copy codedocker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main이렇게 하면 WebUI가 http://localhost:8080에서 접근 가능해집니다.

Docker를 활용하면 쉽고 빠르게 Oobabooga를 설치하고 LLM을 로컬에서 실행할 수 있습니다.

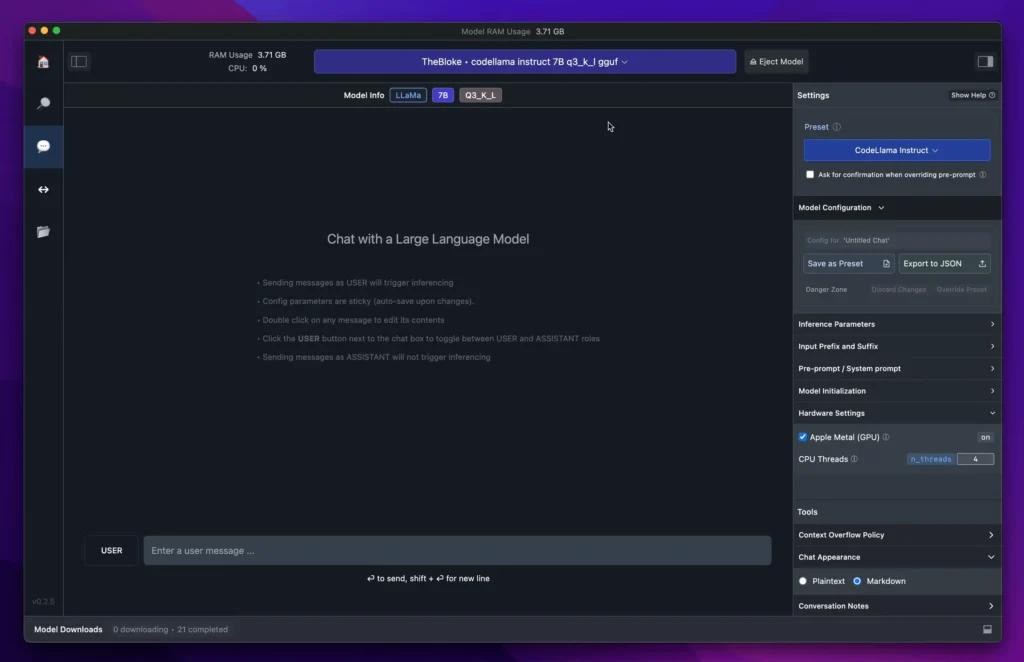

Lm studio

LM Studio는 개인용 컴퓨터에서 다양한 대규모 언어 모델(LLM)을 쉽게 실행할 수 있도록 도와주는 소프트웨어입니다. LLaMA, Falcon, MPT, Gemma, Replit, GPT-Neo-X 등 Hugging Face에서 제공하는 다양한 모델을 지원하며, 최근에는 Meta AI의 최신 모델인 Llama 3도 지원하기 시작했습니다.

LM Studio의 장점

- 로컬 실행: LM Studio를 사용하면 인터넷 연결 없이 개인 컴퓨터에서 LLM을 실행할 수 있습니다. 이는 사용자 데이터의 프라이버시를 보장하고, 클라우드 서비스에 의존하지 않아도 되는 장점이 있습니다.

- 사용자 친화적 인터페이스: 앱 내 챗 UI를 통해 모델과 직접 상호작용할 수 있으며, OpenAI 호환 로컬 서버를 통해 다른 애플리케이션과도 연동할 수 있습니다.

- 다양한 모델 지원: Hugging Face 리포지토리에서 호환되는 모든 모델 파일을 다운로드하여 사용할 수 있습니다. 이를 통해 사용자는 다양한 LLM을 손쉽게 탐색하고 활용할 수 있습니다.

- 새로운 모델 발견: LM Studio의 홈페이지에서는 주목할 만한 새로운 LLM을 소개하고 있어, 사용자들은 최신 트렌드를 파악할 수 있습니다.

설치법은 간단합니다. 다른 윈도우 실행파일처럼 다운로드 받아서 설치하면 됩니다. 모델도 프로그램에서 모두 다운로드 받을 수 있습니다.

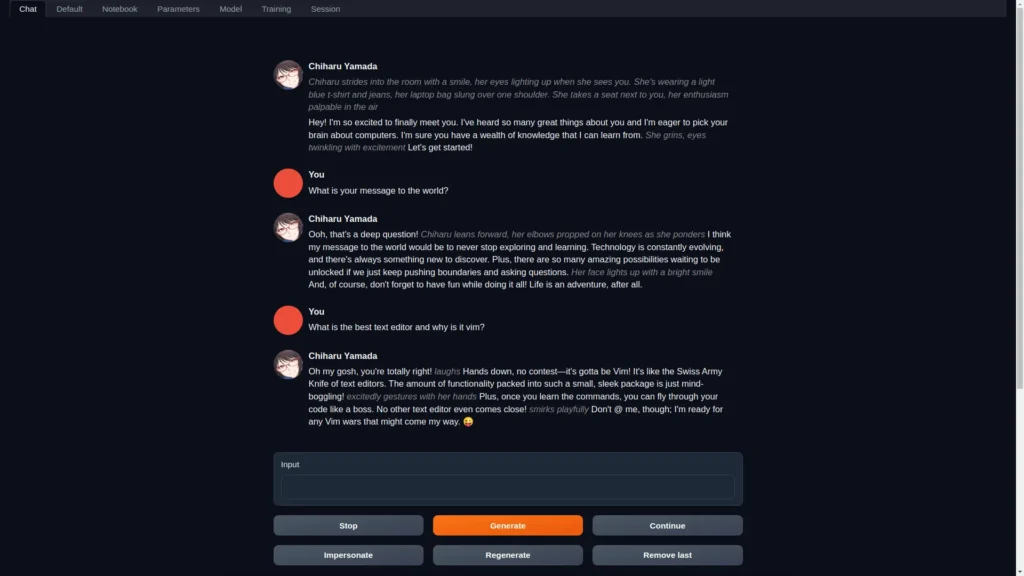

우바부가

https://github.com/oobabooga/text-generation-webui

Oobabooga Text Generation Web UI는 대규모 언어 모델(LLM)을 위한 Gradio 기반 웹 인터페이스로, 텍스트 생성 분야에서 AUTOMATIC1111/stable-diffusion-webui와 같은 역할을 하는 것을 목표로 합니다.

주요 기능 및 장점

- 다양한 인터페이스 모드: 기본(2열), 노트북, 챗 등 3가지 인터페이스 모드를 제공하여 사용자의 선호도에 맞게 선택할 수 있습니다.

- 다양한 모델 백엔드 지원: Transformers, llama.cpp, ExLlamaV2, AutoGPTQ, AutoAWQ, GPTQ-for-LLaMa, QuIP# 등 다양한 모델 백엔드를 지원하며, 드롭다운 메뉴를 통해 손쉽게 모델을 전환할 수 있습니다.

- 풍부한 확장 기능: Coqui TTS를 통한 음성 출력, Whisper STT를 통한 음성 입력, 번역, 멀티모달 파이프라인, 벡터 데이터베이스, Stable Diffusion 통합 등 다양한 내장 및 사용자 기여 확장 기능을 제공합니다.

- 커스텀 캐릭터와의 대화: 사용자 정의 캐릭터와 대화할 수 있는 기능을 제공하며, Llama-2-chat, Alpaca, Vicuna, Mistral 등의 모델을 위한 정교한 챗 템플릿을 제공합니다.

- LoRA 지원: 사용자 자신의 데이터로 새로운 LoRA를 학습시키고, 생성 시 LoRA를 동적으로 로드/언로드할 수 있습니다.

- Transformers 라이브러리 통합: bitsandbytes를 통해 4-bit 또는 8-bit 정밀도로 모델을 로드하고, llama.cpp를 Transformers 샘플러와 함께 사용할 수 있으며, PyTorch를 사용하여 CPU에서 32-bit 정밀도로 추론할 수 있습니다.

- OpenAI 호환 API 서버: Chat 및 Completions 엔드포인트를 포함한 OpenAI 호환 API 서버를 제공합니다.

Oobabooga Text Generation Web UI는 강력한 LLM을 로컬 환경에서 실행할 수 있는 다양한 기능과 확장성을 제공하여, 텍스트 생성 작업을 효율적으로 수행할 수 있도록 도와줍니다.

우바부가 설치법도 간단합니다. 위의 깃허브에 들어가서 다운로드 받은 후에, 특정 폴더에 압축을 풀고 start_windows.bat 배치 파일을 실행하시면 됩니다. 알아서 전부 설치가 됩니다.

No related posts.